Un porc, un algoritm şi o nulitate simpatică

În ultimele două sute de ani, împărțirea cunoașterii și puterii între oamenii-bărbați și oamenii-femei s-a echilibrat simțitor. Distincția însăși pare să nu mai fie atît de importantă și să-și piardă tăișul binar, ori-ori. Ce ne așteptăm însă de la o societate în care deciziile sînt luate, în bună parte, de inteligențe artificiale?

Algoritmii sînt tot mai importanți în producerea informațiilor, modelarea succesului, clasificarea oamenilor și selectarea candidaților finali pentru diferite roluri. Algoritmii joacă un rol în știrile pe care le citim, în prețurile și oportunitățile pe care le vedem online, în accesul la asigurări sau credite și în succesul CV-ului postat pentru un loc de muncă. De aceea, inteligențele artificiale care povestesc lumea și decid ce fel de oameni sîntem au intrat tot mai mult în vizorul atenției publice. Ei bine, veștile sînt amestecate.

Vestea proastă este că, deocamdată, algoritmii par să nu se dea înapoi de la discriminări, unele chiar grosolane față de standardele sociale curente. Conceptele de „prejudecată algoritmică“ sau „părtinire algoritmică“ sînt tot mai viu ilustrate.

În ceea ce privește algoritmii ce mediază cunoașterea lumii, boții povestitori și cenzori, sîntem actorii unei tabloidizări digitale ce nu contenește să uimească. Relatările ce stîrnesc controverse sînt productive – fie că sînt adevărate sau false, sexiste, rasiste sau violente în alt fel. Fiindcă le citim, le urîm și le iubim, ele ne implică și astfel generează prețioasele date despre noi – marfa privilegiată a mediului online. Bigotismul narativ este pe val – sau este chiar valul.

În ceea ce privește algoritmii ce ne observă, ne sortează și ne ierarhizează, situația este cam la fel de sumbră. Mi a plăcut și vă recomand prezentarea lui Joy Buolamwini de la TEDxBeaconStreet. Buolamwini se definește ca o „poetă a codului“ și, acum cîțiva ani, lucra la MIT Media Lab cu un software de recunoaștere facială. Singura mică, minusculă problemă era că… fața ei nu era recognoscibilă pentru acești algoritmi. Din perspectiva lor computațională, chipul său nu părea uman. Aceștia se antrenaseră să detecteze fețe prin seturi mari de date precum Labeled Faces in the Wild, o colecție de 13.000 de fotografii. De unde să vină problema? La o numărătoare atentă, 83% din fețele din colecție erau albe și 78% erau masculine, or, Buolamwini este o femeie de culoare. Nu e de mirare că figura sa cam ieșea din tipare. Prin urmare, poeta și-a realizat proiectul purtînd pe chip o mască albă… pentru a putea fi „recunoscută“.

Alte exemple sînt dezvăluite de Cathy O’Neil. Ea identifică niște „weapons of math destruction“: algoritmi care reproduc și întăresc inegalitățile sociale, prin ceea ce învață despre lume și deciziile pe care le impun. O’Neil arată, în discursurile sale la TED și Google și în cartea sa, tradusă recent și în română, cum se face că acești algoritmi sînt sexiști, rasiști și întăresc prejudecățile curente. O problemă sînt seturile de date pe care sînt antrenați. Algoritmii învață ce înseamnă „succesul“ și ce înseamnă „eșecul“ din exemplele disponibile – dar, desigur, succesul în lumea reală include adesea influența prejudecăților și proceselor de acumulare a avantajelor și dezavantajelor pe parcursul vieții. Aceste prejudecăți ajung să fie încorporate în deciziile algoritmice, în numele obiectivității matematice. Mai mult, deoarece aceste programe sînt protejate de drepturi de proprietate intelectuală, ele nu pot fi inspectate. Algoritmii decid adesea fără drept de apel.

Pentru a evita discriminarea, oamenii și organizațiile din ziua de azi își „înghiontesc“ sau își constrîng deciziile prin principii morale codificate în legi, căutînd echitatea împotriva prejudecăților. Algoritmii însă iau de bun ceea ce văd. Oamenii au învățat că o evaluare corectă și profitabilă a valorii necesită uneori să ignori informația, să nu știi dacă un candidat e femeie, dacă are dizabilități, dacă este de culoare sau dacă este musulman. De aceea marile orchestre realizează audiții în orb pentru a-și selecta muzicienii. Audierea soliștilor pitiți/pitite în spatele unei perdele duce la angajarea a semnificativ mai multe femei în orchestrele prestigioase, după cum observă Claudia Goldin și Cecilia Rouse în analiza lor despre „orchestrarea imparțialității“ – cu condiția să nu se dea de gol la intrarea pe scenă, prin sunetul tocurilor. Algoritmii sînt însă avizi de date și nu știu să ignore informația. Ei caută tot mai multe indicii, urmăresc toate pattern-urile detectabile – chiar dacă acestea încorporează dezavantaje și prejudecăți active de sute de ani.

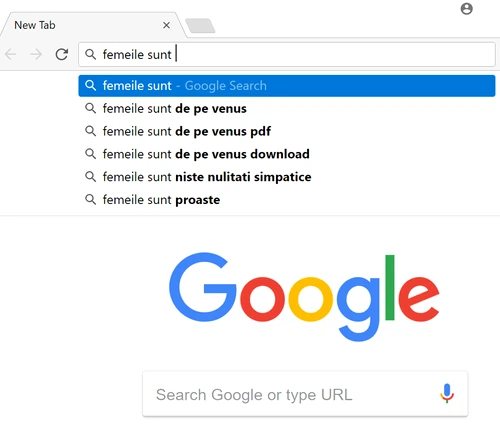

O ilustrație simplă a părtinirii încorporate în datele online este oferită de algoritmii Google de autocompletare a căutărilor. Uneori autocomplete poate fi poetic – vezi versurile albe captate pe googlepoetics.com. Pentru căutări mai mundane, algoritmul pur și simplu ne propune ceea ce știam deja. Cu ocazia scrierii acestui text, am aflat din nou că bărbații sînt de pe Marte și femeile de pe Venus… cu toate consecințele aferente. (Sugestiile oferite mie de algoritmul Google autocomplete, pe 26 februarie 2018: bărbații sînt „niște porci“, via inimi frînte; femeile sînt „niște nulități simpatice“, via culmile disperării – vezi foto.)

Algoritmi competitivi

Un studiu realizat de Universitatea Boston și Microsoft Research în 2016 poartă titlul sugestiv „Man is to Computer Programmer as Woman is to Homemaker?“ Cercetătorii au observat că algoritmii antrenați pe colecțiile de știri învață foarte repede diviziunea de gen a muncii, pe care se grăbesc să o reproducă în prognoze și recomandări. Bărbații sînt potriviți ca doctori și directori, femeile sînt minunate ca asistente medicale și secretare; bărbații sînt foarte buni ca ingineri, femeile sînt niște casnice excelente. Dacă ne pasă și ne punem mintea, putem evita aceste părtiniri prin crearea unor seturi de date atent configurate nondiscriminatoriu în prealabil. Judecata umană și o doză bună de efort sînt necesare pentru a-i învăța pe algoritmi, ca pe copii, ce diferențe vrem să lăsăm în urmă și ce diferențe vrem să păstrăm. Sînt femeile inginer, bărbații educatori sau afro-americanii violonceliști doar niște excepții de la regulă, niște erori statistice pe care mai bine le ignorăm pentru o predicție eficientă? Sau sînt semne ale unui potențial uman pe care vrem să îl (re)descoperim și să îl însuflețim?

Vestea oarecum bună este că, destul de predictibil, algoritmii vor evolua impredictibil. Pilula amară a discriminării algoritmice actuale poate fi îndulcită de gîndul că ne aflăm în copilăria acestor creaturi. Inteligențele artificiale sînt încă naive în chestiuni psihologice, istorice sau morale. Poate, cînd vor crește mari, va fi altfel.

Totuși, algoritmii nu sînt copii și nu vor deveni oameni. Față de noi, sînt obsesivi, rapizi, neobosiți, continuu racordați la indicatori care îi validează sau îi ucid. Algoritmii muncesc tot timpul, fără oprire, cu viteze de neînchipuit. Pe zi ce trece devin tot mai competitivi – luptîndu se unul cu altul în curse digitale pentru a ajunge primul la destinație, în picosecunde. Ce va însemna pentru oameni această hipercompetiție a algoritmilor? Cînd vom fi evaluați și evaluate ca resurse umane, consumatori sau pacienți, vor produce algoritmii sexiști sau rasiști un avantaj comercial față de cei sensibili la diversitate, sau dimpotrivă?

Întrebarea este dacă algoritmii bigoți își vor servi mai bine stăpînii, mai ales marile corporații și organizații statale sau transstatale, decît algoritmii liberali. Ce tipuri și ce combinații de algoritmi vor avea un rol mai mare în maximizarea profiturilor și în gestiunea riscurilor? Va fi mai profitabil pentru corporații să creeze consumatori/consumatoare cu identități stereotipice sau consumatori nuanțați, diverși, disruptivi? Comerțul actual pare să sugereze prima opțiune: reclamele sînt unul dintre cele mai conservatoare și sexiste medii, cu reprezentări caricaturale și degradante. Este însă posibil ca algoritmii să schimbe regulile jocului, încleștați în hipercompetiții pe care încă nu le imaginăm, căutînd controverse tot mai spectaculoase, gonind spre descoperirea unor nișe și fluxuri comerciale disruptive.

Nu în ultimul rînd, contează cine sînt antrenorii și arbitrii umani ai acestor cohorte digitale. Pe cît de diverse vor fi persoanele care îi creează, îi dresează și îi evaluează, pe atît de sensibili vor fi și algoritmii la oportunitățile comerciale și de securitate ale disruperii sau osificării clișeelor.

În viitorul predictibil, un porc, un algoritm și o nulitate simpatică intră într-un bar. „Ce serviți?“, întreabă barmanul. Algoritmul îl privește amuzat: „Păi, asta e treaba ta să știi!“

Cosima Rughiniș este profesoară la Facultatea de Sociologie și Asistență Socială, Universitatea din București. Cercetările sale examinează cunoașterile controversate ale naturii umane, precum concepțiile despre feminitate și masculinitate, teoriile despre vaccinare și homeopatia.